PBG Análisis – Edición octubre

Revolucionando la Gestión de Portafolios: Cómo el Aprendizaje Automático Potencia el Marco Clásico de Markowitz

Apreciable comunidad de PBG.io,

En el dinámico panorama financiero actual —donde los datos fluyen de manera torrencial y los regímenes de mercado pueden cambiar de la noche a la mañana— las herramientas cuantitativas tradicionales necesitan ser actualizadas. Ese es el mensaje central del artículo “Enhancing Markowitz’s Portfolio Selection Paradigm with Machine Learning” de Marcos López de Prado, Joseph Simonian, Francesco A. Fabozzi y Frank J. Fabozzi (Annals of Operations Research, 2025).

Los autores revisan el modelo de optimización de media-varianza de Harry Markowitz de 1952 —la base de la teoría moderna de portafolios— y muestran cómo el aprendizaje automático (Machine Learning, ML) puede enriquecer, en lugar de reemplazar, este marco conceptual. La idea central es combinar el rigor econométrico con la inteligencia basada en datos para crear portafolios más adaptativos y robustos, adecuados para los mercados que se comportan no lineales y de alta dimensionalidad actuales.

En PBG.io, este enfoque es altamente compatible con nuestra misión. Varias de estas metodologías ya subyacen en nuestro análisis cuantitativo, mientras que otras guían nuestra hoja de ruta para las sucesivas implementaciones. A continuación, presentamos una explicación accesible pero conceptualmente apegada a los principales hallazgos del artículo.

El fundamento: por qué Markowitz necesita ML

Markowitz concibió la construcción de portafolios como un problema de optimización: minimizar la varianza (1) para un rendimiento esperado prestablecido, o maximizar el rendimiento para un nivel de riesgo determinado. El desafío actual consiste en que los mercados son ruidosos (2), los volúmenes de datos son grandes y las suposiciones lineales (3) suelen fallar.

El aprendizaje automático cambia el paradigma desde el “modelado de datos”, que asume un proceso estocástico (4) específico, hacia el “modelado algorítmico”, que se enfoca en la predicción y el reconocimiento de patrones incluso cuando el proceso subyacente es desconocido. Este cambio permite extraer alfa (5) , modelar dependencias no lineales y gestionar el riesgo de formas que la econometría tradicional no puede.

Generación de señales: encontrando estructura en el ruido

Las señales de inversión —cuantitativas o cualitativas— guían la toma de decisiones. ML amplía el conjunto de herramientas para generar señales mucho más allá de la regresión o los modelos ARIMA (6).

- Supervised learning predice etiquetas o valores como rendimientos esperados.

- Unsupervised learning revela estructuras ocultas, como regímenes de volatilidad.

- Reinforcement learning enseña a los agentes (7) a maximizar recompensas acumuladas mediante prueba y error.

- Neural networks detectan patrones temporales y no lineales en los datos de precios.

Los autores destacan la importancia de evaluar las señales con métricas rigurosas — precisión, recall, F1-score y exactitud— para validar su poder predictivo. En PBG.io, los métodos supervisados y no supervisados ya forman parte de nuestras herramientas de análisis en la detección de señales, ayudándonos a identificar activos infravalorados o impulsados por momentum, y se están desarrollando modelos de reinforcement learning para hacer nuestros sistemas de trading más adaptativos.

Selección de características: destilando el universo de factores

No todas las variables aportan valor. Incluir demasiadas puede llevar al sobreajuste (8). Técnicas como LASSO y elastic net eliminan predictores débiles, mientras que los modelos basados en árboles (como random forests) permiten identificar los factores más relevantes.

El artículo muestra cómo estas técnicas doman el llamado “zoológico de factores”, identificando un subconjunto más parsimonioso (9) y explicativo.

En PBG.io, aplicamos y seguimos evaluando técnicas como LASSO y random-forest filtering para garantizar que nuestras estrategias multi-activo destaquen las primas de riesgo más informativas —como momentum, carry o value— minimizando la redundancia. También seguimos analizando cómo implementar de la mejor manera métodos avanzados como las neural networks para el descubrimiento de características no lineales dentro de nuestro marco de optimización de portafolios.

Optimización del portafolio: resolviendo las debilidades de Markowitz

Los autores analizan las principales limitaciones del modelo de Markowitz y las soluciones basadas en ML que hoy las abordan:

- Noise-induced instability. – las matrices de covarianzas empíricas (10) son notoriamente ruidosas. Random Matrix Theory (RMT) y las técnicas de residual eigenvalue denoising de López de Prado filtran los valores propios asociados al ruido, mejorando la estabilidad fuera de muestra (out-of-sample stability).

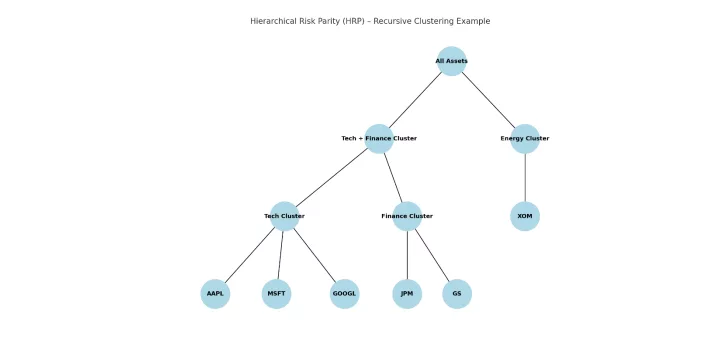

- Input uncertainty. – invertir la matriz de covarianzas amplifica el error de estimación. Hierarchical Risk Parity (HRP) reemplaza esa inversión por un proceso de agrupamiento recursivo, generando asignaciones diversificadas que superan en rendimiento a los portafolios tradicionales de varianza mínima.

- Signal-induced instability (“Markowitz’s curse”). – cuando los activos están altamente correlacionados, pequeños cambios en los parámetros pueden generar grandes oscilaciones en los pesos. Nested Clustered Optimization (NCO) mitiga esto al optimizar primero dentro de los grupos (intra-cluster) y luego entre ellos (intercluster), reduciendo el error cuadrático medio (RMSE11) del portafolio a menos de la mitad frente al modelo clásico.

- IID and normality assumptions. – los mercados muestran colas gruesas (12) y cambios de régimen, por lo que ML permite modelos “regime-aware (13)” y no gaussianos mediante random forests, spectral clustering y reinforcement learning, ajustando dinámicamente la distribución del riesgo entre activos (dynamic risk budgeting).

- Single-period limitations. – la mayoría de los inversionistas toman decisiones multihorizonte. Avances como la optimización de hiperparámetros (14), los modelos gráficos bayesianos y el quantum annealing extienden la optimización en el tiempo y no solo en un momento fijo.

En PBG.io, HRP sustentará nuestro motor de asignación de riesgo, reduciendo drawdowns y rotación de portafolio (turnover). NCO y los modelos sensibles a regímenes están en desarrollo para mejorar la resiliencia ante transiciones de mercado volátiles.

Pruebas de estrés: aprendiendo de los extremos

Las pruebas de estrés tradicionales extrapolan a partir de la historia. ML añade realismo al identificar grupos ocultos y anomalías que revelan posibles riesgos extremos.

Métodos como Gaussian Mixture Models (GMM) y DBSCAN permiten detectar regímenes y valores atípicos asociados a escenarios de estrés —enfoques ya adoptados por firmas como Two Sigma, un fondo cuantitativo líder en el uso de IA y ciencia de datos para inversión sistemática. En PBG.io estamos analizando el uso de técnicas similares para simular choques de mercado y estamos explorando modelos generativos que creen escenarios hipotéticos más realistas.

NLP y Generative AI: convirtiendo texto en alfa

La frontera del ML se ha expandido hacia el procesamiento de lenguaje natural (Natural Language Processing, NLP) y los Generative Language Models (GLM) como GPT. Estos modelos extraen información de sentimiento y eventos de fuentes no estructuradas —como llamadas de resultados, reportes regulatorios o noticias— y las convierten en señales cuantitativas.

También pueden generar narrativas de mercado sintéticas para entrenar modelos o realizar análisis de escenarios. En PBG.io, el análisis de sentimiento ya empieza a complementar nuestros filtros cuantitativos; en lo que respecta a la detección de eventos mediante GLM está prevista para su futura integración.

Desafíos y el camino a seguir

Los autores son claros: el ML no es una panacea. El sobreajuste, la calidad de los datos, la escalabilidad y la transparencia regulatoria siguen siendo desafíos reales. No obstante, con prácticas sólidas de validación cruzada, técnicas de inteligencia artificial explicable y gobernanza disciplinada, el ML puede integrarse de manera responsable al proceso de inversión.

Para PBG.io, este trabajo valida nuestra filosofía híbrida: combinar las finanzas clásicas con la ciencia de datos avanzada para construir portafolios no solo optimizados, sino adaptativos. A medida que continuemos integrando NCO, modelos “regime-aware” y analítica generativa, nuestro objetivo se mantiene firme: ofrecer rendimientos robustos y equilibrados frente al riesgo en un mercado en constante evolución.

Si deseas profundizar en estos conceptos o discutir cómo pueden aplicarse a tu portafolio, estaremos encantados de conversar contigo.

Con aprecio,

El equipo de PBG.io

1- Medida estadística de cuánta volatilidad presentan los rendimientos respecto a su promedio

2- Un mercado ruidoso es aquel en el que los precios se mueven con mucha variabilidad por factores aleatorios o emocionales, más que por cambios reales en el valor de los activos. El “ruido” proviene de decisiones impulsivas, rumores o reacciones exageradas que ocultan las señales verdaderas del mercado

3- Los supuestos de linealidad implican que la relación entre las variables es, en promedio, una línea recta: los cambios en la variable independiente producen cambios proporcionales en la dependiente. Además, se asume que los errores son aleatorios (sin patrón), tienen varianza constante, no están correlacionados entre sí y siguen una distribución aproximadamente normal

4- Un proceso estocástico es un fenómeno que evoluciona a lo largo del tiempo de manera parcialmente aleatoria. Aunque puede seguir ciertas reglas o tendencias, su resultado en cada instante no es completamente predecible, sino que depende del azar. Los precios financieros, por ejemplo, suelen modelarse como procesos estocásticos porque combinan patrones y ruido

5- Rendimientos superiores a un índice de referencia

6- El modelo ARIMA describe series de tiempo combinando patrones pasados (autoregresión), corrección de tendencias (diferenciación) y efectos aleatorios (media móvil) para realizar pronósticos.

7 -Los agentes son entidades que toman decisiones y actúan dentro de un entorno para maximizar una recompensa en función de su experiencia.

8- Un modelo sobreajustado es aquel que funciona bien con datos históricos, pero fracasa en el futuro.

9- Parsimonioso en este contexto significa simple pero suficiente, es decir, que explica bien un fenómeno usando el menor número posible de factores o supuestos.

10- Matrices que miden cómo varían conjuntamente los datos observados entre distintas variables, calculada directamente a partir de muestras reales.

11- El RMSE (Root Mean Squared Error) mide el promedio de los errores de predicción, dando más peso a los errores grandes al elevarlos al cuadrado.

12- “Fat tails” (colas gruesas) se refiere a distribuciones donde los eventos extremos ocurren con mayor frecuencia de lo que predice una distribución normal.

13- Los modelos “regime aware” reconocen y se adaptan a distintos regímenes o entornos del mercado, ajustando su comportamiento según el contexto

14- Un hiperparámetro es una configuración que se elige antes de entrenar un modelo (como la tasa de aprendizaje o el número de capas) que controla cómo aprende el modelo, afectando su precisión y velocidad.

Este contenido es informativo y no constituye asesoramiento financiero, oferta ni solicitud de inversión. Los criptoactivos son volátiles y pueden provocar pérdida total del capital. Resultados pasados no garantizan rendimientos futuros. Sujeto a regulación vigente. Haz tu propia evaluación antes de invertir.